Spis treści

W ciągu ostatnich kilkunastu miesięcy krajobraz marketingu internetowego przeszedł rewolucję, której nie widzieliśmy od czasów powstania samej wyszukiwarki Google. Tradycyjne SEO, oparte na linkach i słowach kluczowych, ewoluuje w stronę AIO (AI Optimization) oraz GEO (Generative Engine Optimization). Dziś użytkownicy coraz rzadziej klikają w niebieskie linki, a coraz częściej oczekują gotowych odpowiedzi od asystentów takich jak ChatGPT, Perplexity czy Gemini.

Dlaczego monitoring obecności marki w modelach AI jest kluczowy?

W świecie, w którym odpowiedzi na zapytania użytkowników są napędzane przez AI marka przestaje być tylko wynikiem wyszukiwania – staje się częścią narracji generowanej przez sztuczną inteligencję. Brak kontroli nad tym, co LLM (Large Language Models) mówią o produktach czy ofercie naszej firmy, niesie ze sobą konkretne ryzyka.

AI może przypisywać marce cechy, których nie posiada, lub błędnie informować o cenach i specyfikacji. Jeśli konkurencja jest cytowana jako rekomendacja, może tracić potencjalnych klientów na najwcześniejszym etapie lejka zakupowego. Wreszcie – modele AI uczą się na danych historycznych, brak dbałości o świeżość treści i poprawność danych technicznych, może skutkować powielaniem przez AI nieaktualnych opinii.

Jak to robić skutecznie?

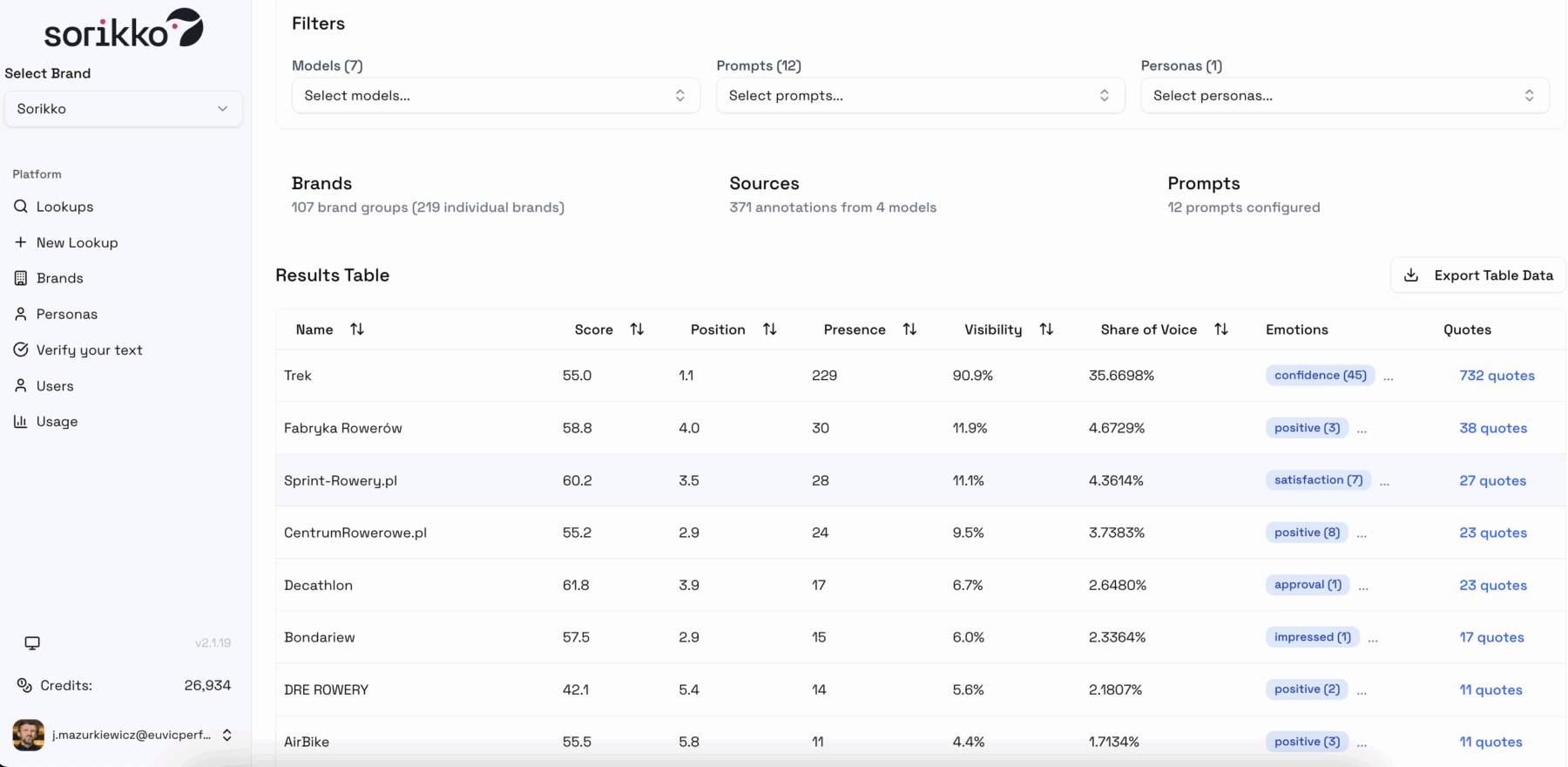

Ręczne wpisywanie zapytań do każdego modelu AI jest nieefektywne. Rekomendujemy korzystanie z profesjonalnych narzędzi analitycznych, takich jak Sorikko. Pozwala ono na systematyczny monitoring tego, jak marka jest pozycjonowana w odpowiedziach LLM, jakie źródła są wykorzystywane do budowania tych odpowiedzi oraz jaki jest ogólny sentyment generowanych treści. To fundament do podejmowania dalszych działań optymalizacyjnych.

Niniejszy artykuł otwiera serię poradników dotyczących widoczności w erze AI. W kolejnych częściach skupimy się na strategii contentowej oraz działaniach off-site. Zaczynamy od fundamentu – warstwy technicznej.

Potrzebujesz wsparcia w optymalizacji swojego serwisu?

Techniczna optymalizacja strony pod modele LLM

Optymalizacja pod kątem AI różni się od klasycznego SEO tym, że agenci AI „konsumują” treść w sposób bardziej surowy, a jednocześnie wymagają większej precyzji w strukturze danych. Oto kluczowe aspekty techniczne, o które należy zadbać.

> Indeksacja i rola silnika Bing

Wiele osób zapomina, że ChatGPT (w trybie wyszukiwania) oraz Perplexity w ogromnym stopniu polegają na indeksie wyszukiwarki Bing. Jeśli Twoja strona nie jest poprawnie indeksowana w ekosystemie Microsoftu, praktycznie nie istniejesz dla dużej części agentów AI.

Regularnie weryfikuj stan indeksacji w Bing Webmaster Tools. Upewnij się, że boty Binga nie napotykają błędów renderowania i mają dostęp do wszystkich kluczowych sekcji witryny.

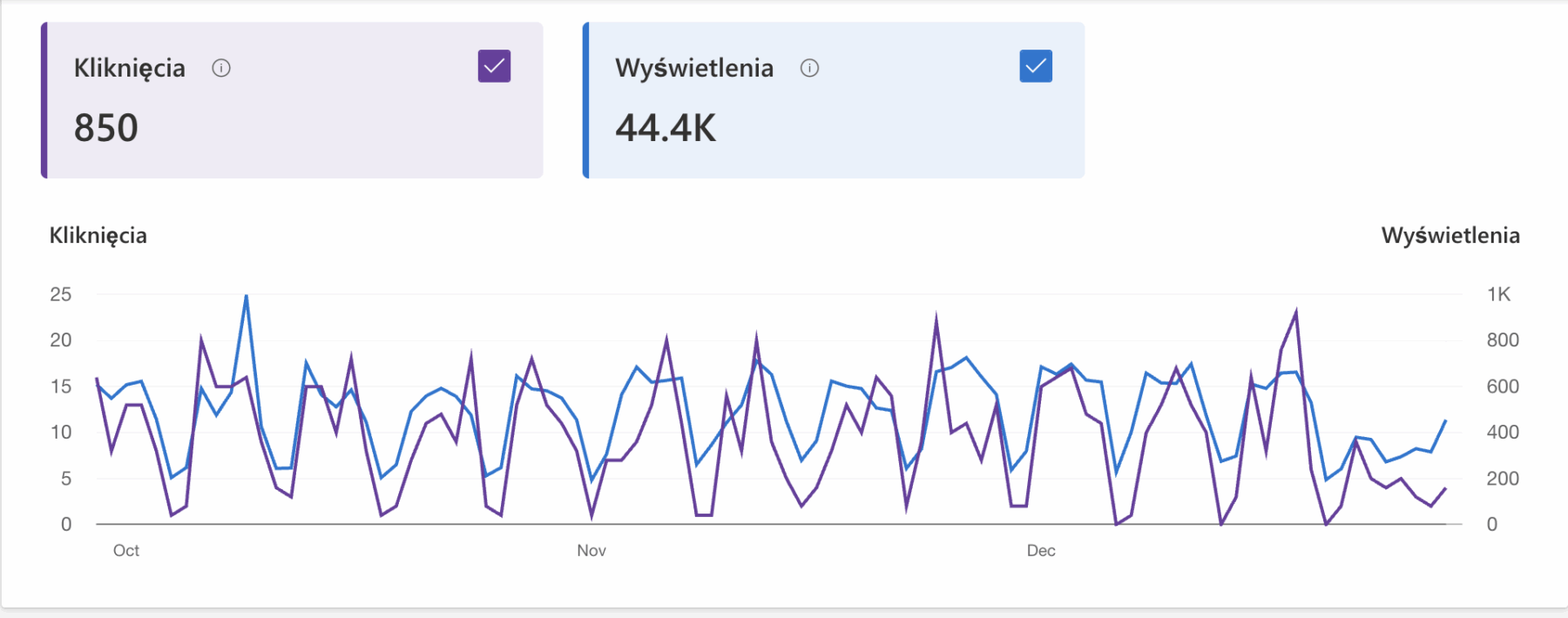

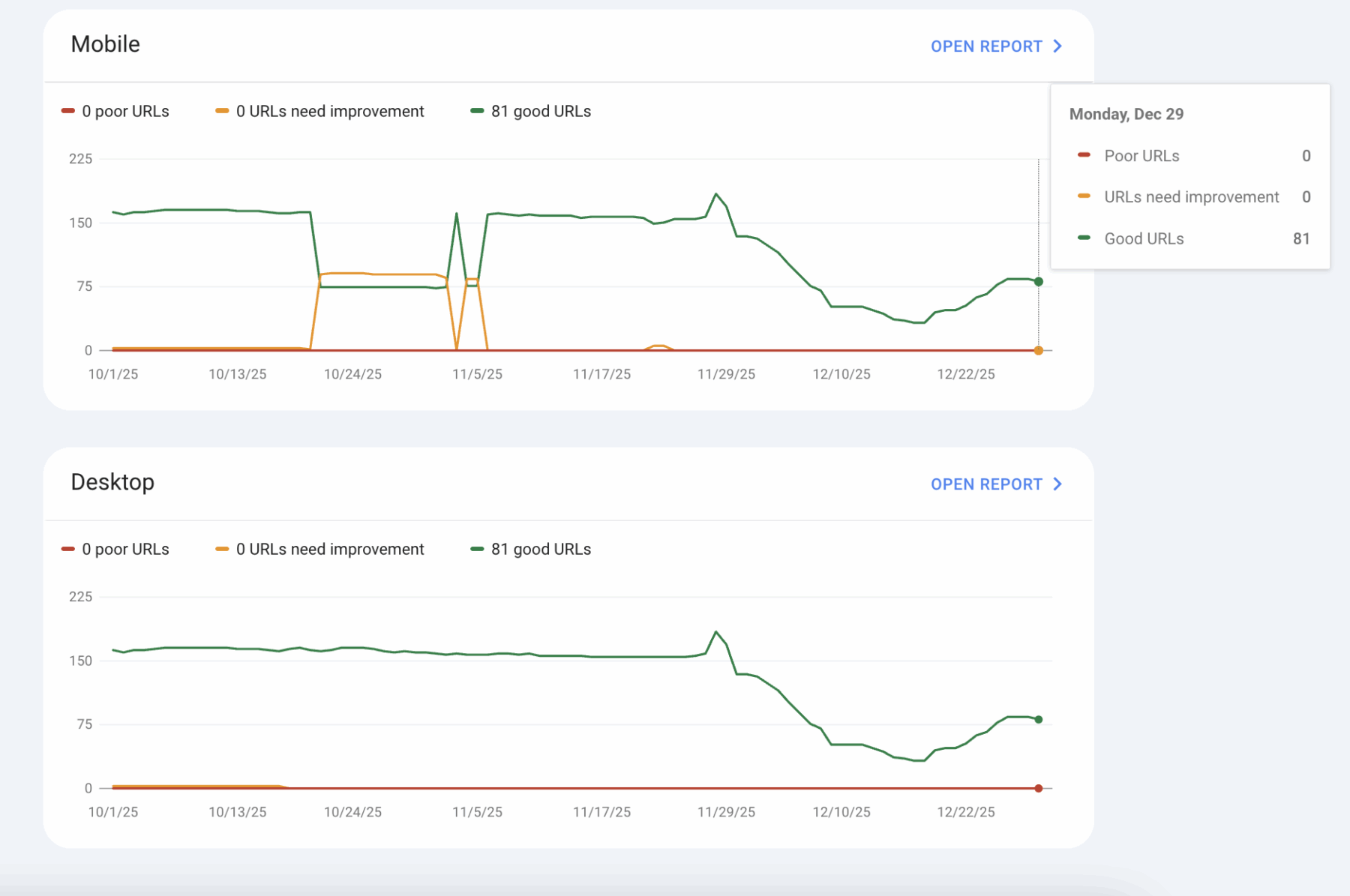

Z kolei widoczność w Gemini, AIO lub AI Mode nie wydarzy się bez obecności w indeksie Google. W tym celu warto weryfikować czy kluczowe URLe witryny (zwłaszcza te zawarte w pliku sitemap.xml zostały przecrawlowane przez bota Google i zaindeksowane). W celu stałej weryfikacji przydają się narzędzia monitorujące, takie jak Revamper11.

Podgląd danych w narzędziu Revamper11

> Dane uporządkowane (Schema.org) – API dla sztucznej inteligencji

Schema to język, którym agenci AI porozumiewają się ze stroną. To swoiste „API”, które pozwala modelom zrozumieć kontekst bez konieczności domyślania się go z tekstu. Nawet jeśli niektóre modele (jak ChatGPT) deklaratywnie skupiają się na czystym tekście, to dane strukturalne są fundamentem ich procesów treningowych i weryfikacyjnych.

Wdroż schematy o najwyższym potencjale:

- Article

Dla blogów i newsów. - FAQ

Z unikalnymi odpowiedziami (unikaj generycznych treści). - HowTo

Idealne dla instrukcji i poradników. - Product

Kluczowe w e-commerce, by AI mogło porównywać konkretne parametry produktów. - Review snippets

Budują wiarygodność i „social proof” w oczach algorytmów.

> Zarządzanie dostępem, czyli rola robots.txt

Tradycyjny plik robots.txt nadal pełni swoją funkcję, ale w dobie AI zyskuje nowe znaczenie. Należy zdecydować, czy pozwalamy botom takim jak GPTBot na skanowanie treści. Blokowanie ich może chronić content przed „kradzieżą”, ale jednocześnie wyklucza z odpowiedzi udzielanych użytkownikom.

Warto również zainteresować się nowym standardem – llms.txt. Jest to proponowany plik tekstowy umieszczany w katalogu głównym, który dostarcza modelom AI zwięzłych instrukcji oraz streszczeń tego, co znajduje się w serwisie, ułatwiając im szybkie i poprawne zrozumienie struktury strony. UWAGA: nie pełni on aktualnie takiej roli jak robot.txt, czyli instrukcji jakie treści mają być indeksowane, a jakie nie, ale może stanowić wartościową ściągę jeśli intencjonalnie zaprzęgnie się go do pracy z agentami AI.

> Pliki Markdown (.md) i czytelność tekstu

Modele LLM uwielbiają strukturę Markdown. Jest ona dla nich znacznie łatwiejsza do przetworzenia niż przeładowany kodem HTML. Rozważ udostępnienie kluczowych dokumentacji lub opisów produktów w formatach przyjaznych dla AI. Pamiętaj, AI „pobiera” czysty tekst. Jeśli Twoja treść jest przeładowana skomplikowanymi elementami wizualnymi, które utrudniają ekstrakcję tekstu, model może ją pominąć.

> Pułapki JavaScript i renderowanie po stronie klienta

To jeden z najczęstszych błędów technicznych. Modele AI często nie „czekają” na wyrenderowanie treści przez JavaScript. Jeśli Twoja kluczowa treść:

- ładuje się dopiero po interakcji użytkownika,

- jest serwowana wyłącznie przez JS (Client-Side Rendering),

- jest ukryta za przyciskami „pokaż więcej”,

…istnieje ogromne ryzyko, że AI jej nie zobaczy.

Stosuj Server-Side Rendering (SSR). Upewnij się, że cały krytyczny tekst jest widoczny w surowym kodzie HTML (Source Code).

> Szybkość strony i TTFB (Time to First Byte)

W dobie AI szybkość przestała być tylko czynnikiem rankingowym UX, a stała się warunkiem przetrwania. Wolne strony są po prostu pomijane przez agentów AI, którzy mają ograniczone zasoby na sesję skanowania.

Celuj w TTFB poniżej 1 sekundy. Jeśli czas odpowiedzi serwera jest zbyt długi, agent AI może przekroczyć limit czasu (timeout) i nigdy nie dojść do etapu cytowania Twojej marki. Szybkość to Twoja przepustka do bycia źródłem w czasie rzeczywistym.

> Zakładki vs akordeony

W e-commerce często stosuje się akordeony, by oszczędzić miejsce. Niestety, dla LLM treść w akordeonach bywa problematyczna, zwłaszcza jeśli wymaga interakcji do załadowania.

Zastąp akordeony czystymi sekcjami z zakładkami w HTML. Pozwalają one na zachowanie dużej ilości tekstu (idealnego do fragmentowania/chunkingu przez AI) w przejrzystym interfejsie użytkownika, pozostając jednocześnie w pełni widocznymi dla crawlerów w prostym kodzie.

Strona “posprzątana” i co dalej?

Optymalizacja techniczna pod LLM to proces zapewniania „maksymalnej czytelności przy minimalnym oporze”. Strona musi być szybka, zrozumiała strukturalnie (Schema) i dostępna bezpośrednio w kodzie HTML, bez barier w postaci ciężkiego JavaScriptu.

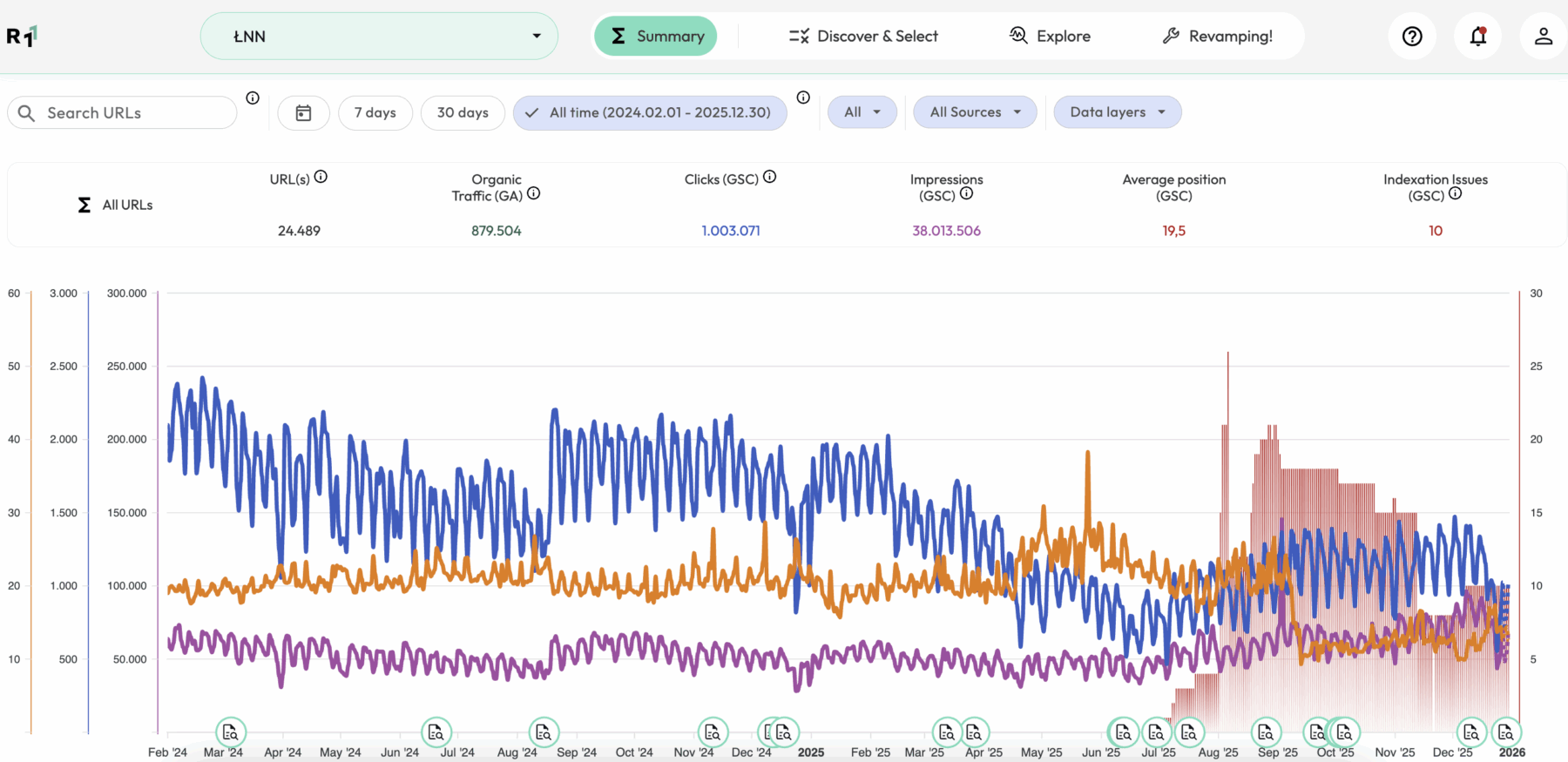

Pierwszym krokiem do sukcesu jest audyt tego, gdzie obecnie znajduje się marka w świadomości sztucznej inteligencji. Narzędzia takie jak Sorikko pozwolą wyznaczyć punkt odniesienia dla wszystkich działań technicznych, które opisałem powyżej.

Podgląd dashboardu narzędzia do monitorowania widoczności w LLM – Sorikko

Jeśli marka potrzebuje profesjonalnego wsparcia w zakresie optymalizacji pod kątem AI, analizy widoczności w modelach LLM lub kompleksowych działań SEO, swoje usługi poleca Digitree Search. Jako spółka z grupy Digitree, odpowiedzialna za ruch organiczny, pomagamy firmom nie tylko odnaleźć się w nowej rzeczywistości Search Generative Experience, ale przede wszystkim przekuć nowe technologie w mierzalny wzrost biznesowy.

Czy Twoja strona jest gotowa na wizytę agenta AI?

W kolejnym artykule z tej serii przyjrzymy się optymalizacji treści (contentu) – dowiesz się, jak pisać, by AI chciało Cię cytować.